MI300发布会上,AMD声称其性能明显优于H100。虽然AMD芯片看起来不错,并且能开箱即用地运行大多数AI。但发布会演示中并没有使用最快的NVIDIA软件,由此造成的差异是巨大的。

NVIDIA近日发布了一篇博客,反驳了AMD最新芯片MI300X在生成式AI的推理处理方面比NVIDIA快40-60%的说法。

在最近的一次发布会上,AMD谈到了H100 GPU与其MI300X芯片相比的推理性能。共享的结果没有使用优化的软件,如果基准测试正确,H100 的速度要快 2 倍。

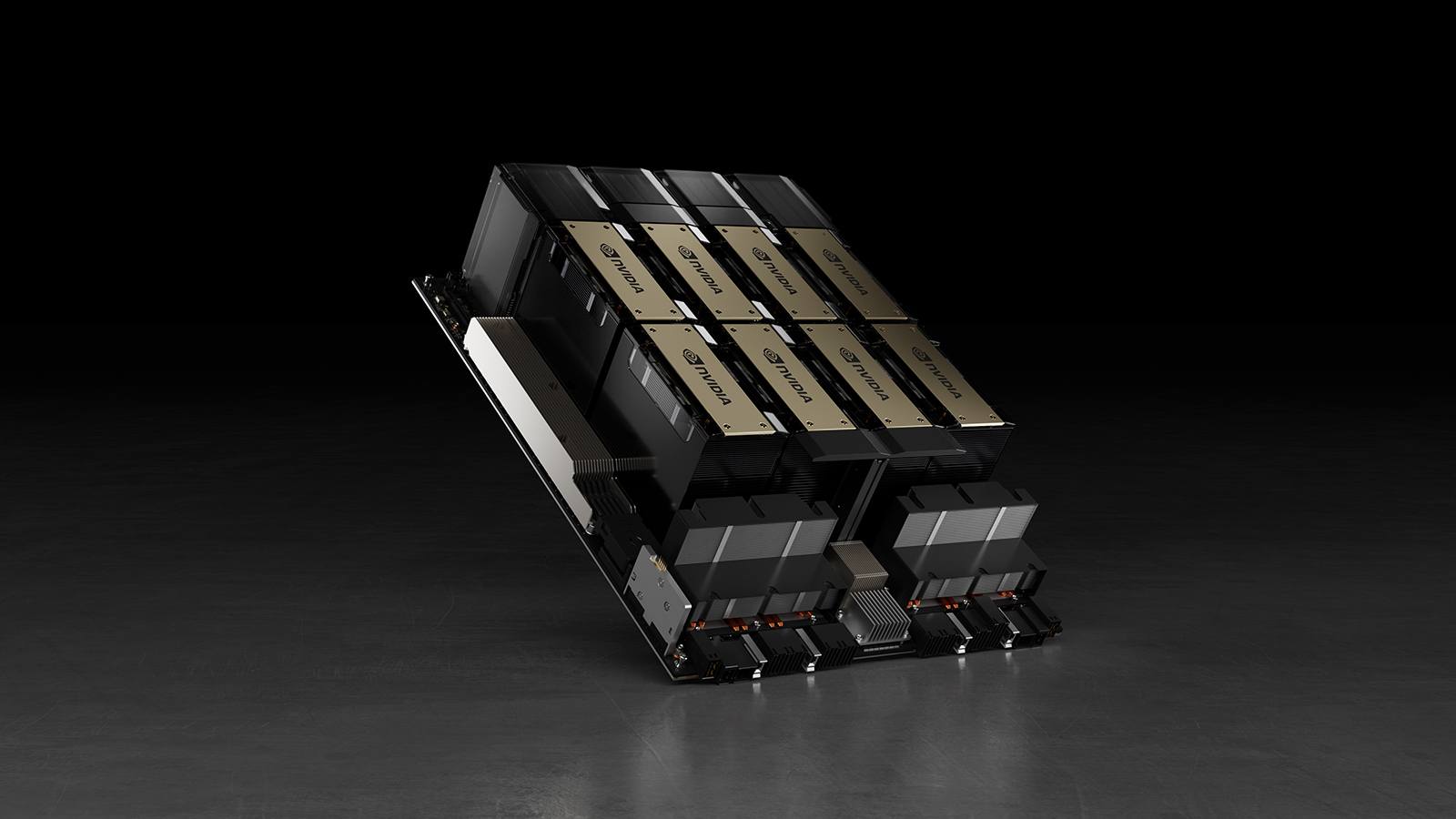

以下是在 Llama 2 70B 模型上配备 8 个 NVIDIA H100 GPU 的单个 NVIDIA DGX H100 服务器的实际测量性能。包括一次处理一个推理请求的“Batch-1”的结果,以及使用固定响应时间处理的结果。

NVIDIA 的最新数据

NVIDIA认为,AMD在其测试中没有使用 NVIDIA 软件,该软件经过优化以提高 NVIDIA 硬件的性能。“虽然Tensor-LLM在GitHub上免费提供,但AMD最近的比较使用了尚不支持Hopper的Transformer引擎,并且缺少这些优化的替代软件,”NVIDIA博客文章说。

此外,AMD没有利用NVIDIA在9月份发布的Tensor-LLM软件,该软件可将LLM的推理性能提高一倍,也没有利用Triton推理引擎。没有Tensor-LLM+没有Transformer引擎+没有Triton=非最佳性能。

文章推测,MI300X GPU可能是第三快的AI芯片,仅次于Cerebras的大型WSE CS2(没有基准测试)和NVIDIA H100。对于那些寻求价格合理的更可用的 GPU 的人来说,这可能已经足够了。

AI硬件市场发展极快,H100已经是上一代产品,H200更加临近了。MI300 FLOP 的规格确实比 NVIDIA H100 好,而且 MI300 也有更多的HBM 内存。但是,它需要优化的软件才能使任何AI芯片增强,并转化为客户价值。AMD ROCm 软件取得了重大进展,但 AMD 仍有许多工作要做。

“人工智能正在快速发展。NVIDIA 的 CUDA 生态系统使我们能够快速、持续地优化我们的堆栈。我们期待通过每次软件更新继续提高 AI 性能”NVIDIA表示。

全部评论