北京时间3月19日凌晨1点到3点,爱穿皮衣的NVIDIA CEO黄仁勋在GTC开幕的主题演讲中讲了两个多小时,在这两个多小时里,黄仁勋谈到了AI的未来,NVIDIA即将要量产和推出的新产品,以及更多的大模型和开发套件。

Agentic AI 时代来临,但未来在物理AI

与前几年的GTC不一样的是,这次黄仁勋没有一上台就介绍NVIDIA的新硬件产品,而是花了40多分钟在讲AI的未来。回顾AI的发展历史,他认为AI起步于感知AI(Perception AI),那时候,人们可以利用AI的技术来理解图像、文字和声音等等。到了生成式AI时代,人们可以通过生成式AI的技术来生成文字、视频和声音,甚至在医疗健康领域,可以用生成式AI的技术来生成小分子化合物,以加速药物发现的进程。

而现在,我们来到了代理式AI(Agentic AI)时代,我们可以借助AI来感知、推理、规划,并采取行动。紧接着就是下一个浪潮---物理AI(Physical AI),这项技术是数字智能与物理世界的无缝结合,使机器能够通过传感器感知环境,理解物理规律,并在现实物理世界中执行复杂的任务。而且不论是Agentic AI还是物理AI,其底座都是生成式AI。

Agentic AI其实不仅仅是一个生成式AI的模型,而是一个多功能复杂的系统。在这个系统中我们可以设计不同的AI代理。借助于AI代理,我们在工作、生活中使用到的一些软件,会从单纯的专项工具,变为协助我们完成复杂工作的智能劳动力。比如说AI Agent可以自主的规划最佳的工具组合,采用工具来检索信息,甚至可以与其他的代理来进行协作,再对结果进行评估和迭代优化。通过反馈,来不断的改进等等。

在黄仁勋看来,Agentic AI讲带来AI的效率革命。Agentic AI时代,Token被视为AI的语言和货币,而NVIDIA的立身之本在于越来越高效地处理Token,同时单位算力成本和能耗下降。首先,不同于生成式AI靠预测下一个Token,Agentic AI是需要无数次调用模型尝试可能性,同时反思、验证自己的答案,其所需要的Token是此前的100多倍。测试阶段Scaling Law才刚刚开始。

因此,黄仁勋预计,到2030年末,数据中心建设支出将达到1万亿美元。

在硬件方面,NVIDIA也带来了今年下半年即将量产出货的Blackwell Ultra芯片,数据中心超级芯片Grace Blackwell NVLink72,并透露预计2026年推出下一代Rubin芯片及方案,2028年推出Feyman平台。网络方面,NVIDIA发布了AI以太网平台Spectrum-X,CPO交换机、个人电脑方面,推出了DGX Spark和DGX Station两款个人AI电脑/计算机,首款开源人形机器人功能模型——GR00T N1等解决方案,还有新机器人亮相。

针对数据中心的新产品

AI迈向推理时代,计算需求迅速增加。黄仁勋在主题分享中透露,2024年美国前4大云服务厂商总计采购了130万颗Hopper架构GPU芯片,2025年已经采购了360万颗Blackwell GPU。

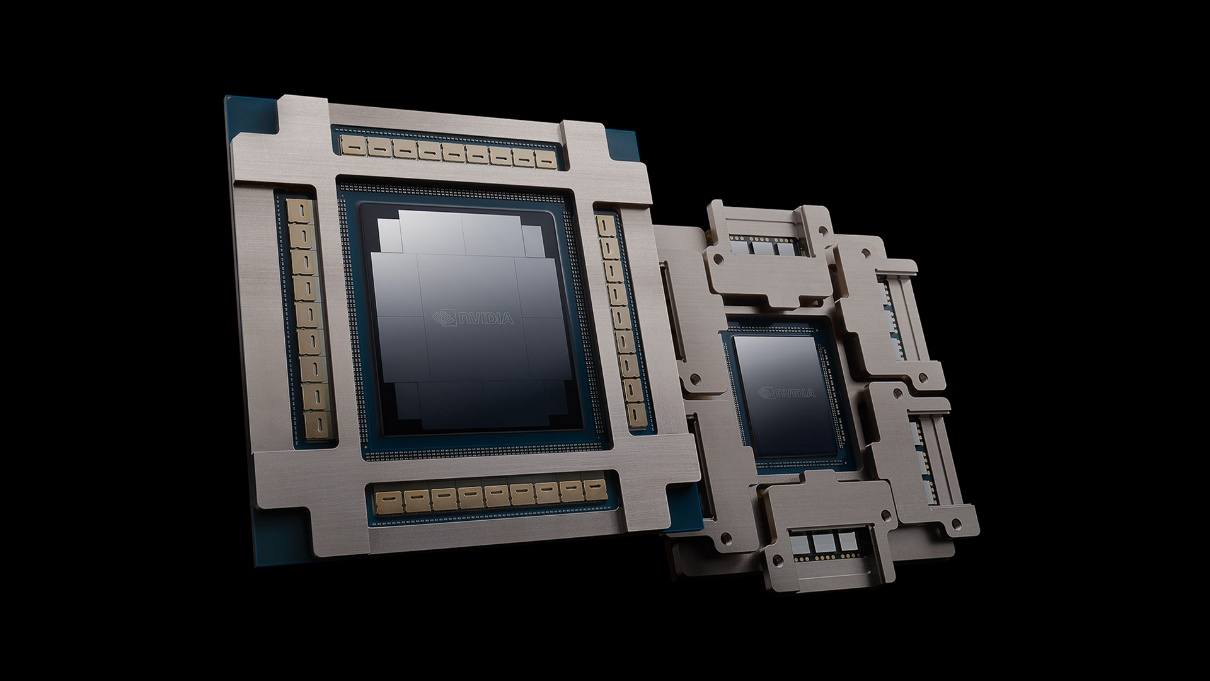

在本次GTC大会上,黄仁勋正式介绍了今年下半年将会量产的NVIDIA新一代数据中心旗舰GPU------ Blackwell Ultra(GB300)。据他介绍,Blackwell Ultra为AI推理时代而设计,是全球首个288GB HBM3e GPU,像拼乐高一样通过先进封装技术将2块掩膜尺寸的GPU拼装在一起,可实现多达1.5倍的FP4推理性能,最高15PFLOPS。

具体参数如下:

- 算力:NVL72机柜,单机柜支持1.1EFLOPS的FP4推理算力,平均单卡15.3PFLOPS FP4算力,比GB200提高50%。

- 指令:增加了全新Attention指令,Attention计算性能翻倍,这超过了此前市场预期。

- 存储:单机柜配备20TB HBM和40TB DRAM,折算单卡约为288GB,相比GB200提升50%。

- 网卡:配备CX8网卡,单机柜14.4TB/s带宽,平均单卡200GB/s,相比GB200带宽翻倍。

升级后的GB300 NVL72设计,提高了能效和可服务性,通过降低成本和能耗来推进AI推理民主化。GB300 NVL72预计将在英伟达端到端全托管AI平台DGX Cloud上提供。与Hopper相比,HGX B300 NVL16在大语言模型上的推理速度加快至11倍,计算能力增加到7倍,内存增至4倍。

对于Blackwell的下一代产品及下下一代产品,黄仁勋也提前剧透了。他在主题分享中展示了两个机架级解决方案,即Vera Rubin NVL144和Rubin Ultra NVL576。其中,Vera Rubin由Rubin GPU和Vera CPU组成。Vera CPU拥有88个定制Arm核心、176个线程。Rubin由两块掩模尺寸的GPU组成,拥有288GB HBM4内存,FP4峰值推理能力可达50PFLOPS,预计2026年下半年上市;Rubin Ultra NVL576的FP4峰值推理算力高达15EFLOPS,FP8训练算力达到5EFLOPS,足足是GB300 NVL72的14倍,将于2027年下半年推出。

这两款新产品的具体参数如下:

【Vera Rubin NVL144:26H2上市】

- 整机柜:144卡,相比GB系列NVL72规模翻倍。

- 算力:单机柜3.6EFLOPS FP4推理算力,约为GB300的3.3倍,折合单卡25EFLOPS,相比GB300提升幅度约66%,与工艺变化相吻合。

- 存储:(单卡)HBM带宽达到13TB/s,相比GB300提升60%。

- CPU:Vera芯片为88核带有超线程的芯片,总线程数176。

- NVLink:配备NVLink6芯片,单机柜交换带宽260TB/s,NVSwitch6单芯片带宽达到3.6TB/s,相比GB系列机柜翻倍,折算单卡1.8TB/s,与GB系列相同。

- 网卡:配备CX9网卡,单机柜带宽28.8TB/s,相比GB300带宽翻倍,折算单卡200GB/s,与GB300持平。

- 交换机:配备Spectrum6 CPO交换机,带宽翻倍达到102T。

【Rubin Ultra NVL576:27H2上市】

- 算力:单机柜15EFLOPS FP4推理算力,相比NVL144约为4倍提升,与柜内卡数提升幅度相近,约为GB300的14倍。

- HBM:单卡配备4 reticle size芯片(4个计算die)配备16颗HBM4E,单卡容量达到1TB,超预期。此前在ComputeX 2024上的路线图显示的仍是单卡配备12颗HBM4,本次HBM规模相比2024路线图的规划明显提升。

- 整机柜:从单机柜FP4提升幅度来看,整机柜配备实际Rubin Ultra卡数或为288个,算力等效于576个Rubin。

【Feyman平台:2028上市】

- GPU为Feynman,CPU仍为Vera。

- NVlink:配备NVSwitch8。

- 交换机:Spectrum7,204T CPO交换机,带宽相比Rubin NVL144翻倍。

开启硅光新篇章,发布CPO交换机

硅光芯片具有高运算速度、低功耗、低延时等特点,且不必追求工艺尺寸的极限缩小,在制造工艺上,也不必像电子芯片那样苛刻,必须使用EUV等先进光刻机设备。因此,硅光芯片近几年受到业界关注。目前,虽然NVIDIA没有直接将硅光芯片技术使用到AI芯片上,但他们与台积电合作,采用了台积电的硅光子平台 Compact Universal Photonic Engine (COUPE),该平台使用台积电的 SoIC-X 封装技术,同时结合了电子集成电路(EIC)与光子集成电路(PIC),打造出两款名为 Spectrum-X 和 Quantum-X 采用硅光子技术的交换机。

因此,在今年的GTC大会上,NVIDIA宣布推出全新共封装(CPO)的NVIDIA Spectrum-X和 NVIDIA Quantum-X硅光网络交换机,使AI工厂能够跨区域连接数百万GPU,同时大幅降低能耗和运营成本。NVIDIA在大规模平台上实现了电子电路与光通信的融合。

与传统方法相比,英伟达光交换机集成了光学创新,将激光器减少至1/4,每端口1.6Tb/s,可提供3.5倍的能效、63倍的信号完整性、10倍的大规模网络弹性、1.3倍快的部署时间。

其中,Spectrum-X光交换机将在2026年推出,有多种配置,包括Quantum 3450-LD(144个800GB/s端口,背板带宽115TB/s,液冷)、Spectrum SN6810(128个800GB/s端口,背板带宽102.4TB/s,液冷)和Spectrum SN6800(512个800GB/s端口,背板带宽409.6TB/s,液冷),上述产品统一归类到“NVIDIA Photonics”,由NVIDIA和多家CPO合作伙伴共同开发。整合光模块的Photonics交换机相比传统交换机,性能可以提升3.5倍,部署效率也可以提升1.3倍,以及10倍以上的扩展弹性。

全球最小超算,桌面AI计算机

NVIDIA还发布了由 NVIDIA Grace Blackwell 平台驱动的DGX个人AI超级计算机------DGX Spark和DGX Station。其中,DGX Spark的前身为 Project DIGITS,支持AI开发者、研究人员、数据科学家和学生,在台式电脑上对大模型进行原型设计、微调和推理。用户可以在本地运行这些模型,或将其部署在NVIDIA DGX Cloud或任何其他加速云或数据中心基础设施中。

DGX Spark将以前仅在数据中心可用的Grace Blackwell架构的强大功能延伸到了台式电脑。开发DGX Spark的全球系统制造商包括华硕、Dell、HP Inc和联想。

DGX Spark的核心是NVIDIA GB10 Grace Blackwell超级芯片,已针对台式电脑外形规格进行了优化。GB10配备功能强大的NVIDIA Blackwell GPU,支持第五代Tensor Core和FP4,每秒计算次数高达1,000万亿次(1000 AI TOPS),适用于借助前沿的AI推理模型(包括NVIDIA Cosmos-Reason世界基础模型和NVIDIA GR00T N1机器人基础模型)进行微调和推理。

GB10超级芯片采用NVIDIA NVLink-C2C互连技术,提供CPU+GPU相结合的一致性内存模型,带宽是第五代PCIe的五倍。因此,这一超级芯片能够访问GPU和CPU之间的数据,为内存密集型AI开发者工作负载优化性能。该AI计算机的预定在3月19日就已经开放。

DGX Station是一款基于Blackwell Ultra的新型高性能桌面级超级计算机,为桌面带来了数据中心级别的性能,用于AI开发,今年晚些时候可从NVIDIA制造合作伙伴处获得。这是第一个采用英伟达GB300 Grace Blackwell Ultra桌面超级芯片构建的台式机系统,拥有784GB超大统一系统内存,还有支持800Gb/s网络连接的ConnectX-8 SuperNIC,AI性能达到20PFLOPS(20,000 AI TFLOPS)。

数据中心、桌面和笔记本电脑GPU

NVIDIA还发布了RTX Pro Blackwell系列工作站和服务器GPU,提供加速计算、AI推理、光线追踪和神经网络渲染技术,使其数据中心GPU从桌面到移动工作站提供动力。

新产品系列包括:

● 数据中心 GPU: NVIDIA RTX PRO Blackwell 服务器版;

● 桌面 GPU: NVIDIA RTX PRO Blackwell 工作站版、NVIDIA RTX PRO Blackwell Max-Q 工作站版、NVIDIA RTX PRO 5000 Blackwell、NVIDIA RTX PRO 4500 Blackwell 和 NVIDIA RTX PRO 4000 Blackwell ;

● 笔记本 GPU: NVIDIA RTX PRO 5000 Blackwell、NVIDIA RTX PRO 4000 Blackwell、NVIDIA RTX PRO 3000 Blackwell、NVIDIA RTX PRO 2000 Blackwell、 NVIDIA RTX PRO 1000 Blackwell 和 NVIDIA RTX PRO 500 Blackwell。

RTX PRO Blackwell GPU 通过提供卓越的性能、效率和扩展性,释放生成式、代理式和物理 AI 的潜力。

NVIDIA RTX PRO Blackwell GPU 具有以下特点:

● NVIDIA 流式多处理器 : 提供高达 1.5 倍的更快吞吐量,新的神经着色器将 AI 集成到可编程着色器中,推动下一个十年 AI 增强图形创新。

● 第四代 RT Core: 相比上一代性能提升高达 2 倍,可创建照片级真实、物理精确的场景和复杂 3D 设计,并针对 NVIDIA RTX™ Mega Geometry 进行了优化。

● 第五代 Tensor Core: 提供高达 4,000 AI TOPs 的性能,并增加了对 FP4 精度和 NVIDIA DLSS 4 多帧生成的支持,开启 AI 赋能图形的新时代,能够更快地运行和原型化更大的 AI 模型。

● 更大、更快的 GDDR7 显存:提升带宽和容量—工作站和服务器最高 96GB,笔记本最高 24GB。 这使应用程序运行更快,可处理更大、更复杂的数据集,从处理大型 3D 和 AI 项目到探索大规模虚拟现实环境。

● 第九代 NVIDIA NVENC: 加快视频编码速度,提升专业视频应用的质量,并增加对 4:2:2编 码的支持。

● 第六代 NVIDIA NVDEC: 提供高达两倍的 H.264 解码吞吐量,支持 4:2:2 H.264 和 HEVC 解码。 借助高质量视频回放,专业人员可加速视频数据采集,并使用高级 AI 赋能视频编辑功能。

● 第五代 PCIe: 支持第五代 PCI Express,提供比上一代双倍的带宽,提升 CPU 显存数据传输速度,为数据密集型任务提供更快的性能。

● DisplayPort 2.1:驱动高分辨率显示器,支持高达 4K 480Hz 和 8K 165Hz。 增加的带宽实现无缝多显示器设置,而高动态范围和更高的色深支持为视频编辑、3D 设计和直播等任务提供更精确的色彩准确度。

● 多实例 GPU(MIG): RTX PRO 5000 系列桌面系列 GPU 具有 MIG 技术,能够将单个GPU 安全分区为两个实例(5000 系列)。 故障隔离旨在防止工作负载干扰,为不同工作负载提供安全、高效的资源分配,最大化性能和灵活性。

新的笔记本电脑 GPU 还支持最新 NVIDIA Blackwell Max-Q 技术,借助 AI 智能且持续地优化笔记本电脑性能和功耗。

通过神经渲染和 AI 增强工具,NVIDIA RTX PRO Blackwell GPU能以惊人的速度和效率创建令人惊艳的视觉效果、真实环境的数字孪生和沉浸式体验。这些 GPU 专为提升 3D 计算机辅助设计和建筑信息模型工作流而打造,为设计师和工程师提供卓越的性能,用于复杂建模、渲染和可视化。

在供货方面,NVIDIA RTX PRO 5000、RTX PRO 4500 和 RTX PRO 4000 Blackwell GPU 将于今年夏季通过 BOXX、戴尔、惠普和联想以及全球分销合作伙伴提供。NVIDIA RTX PRO Blackwell 笔记本电脑 GPU 将于今年晚些时候通过戴尔、惠普、联想和雷蛇提供。

AI推理和AI智能体软件

随着AI推理逐渐成为主流,AI模型在处理每个提示时都会生成数以万计的Token用于“思考”。提高推理性能的同时,不断降低推理成本,可加速服务提供商的增长,并增加收入机会。因此,为了高效地编排和协调大量GPU上的AI 推理请求,确保AI工厂实现运行成本最小化、Token收益最大化,NVIDIA推出了一款开源推理软件NVIDIA Dynamo。

NVIDIA Dynamo是NVIDIA Triton推理服务器的后续产品,旨在为部署推理AI模型的AI工厂最大化其Token收益。它协调并加速数千个 GPU 之间的推理通信,并使用分离服务将大语言模型 (LLM) 的处理阶段和生成阶段在不同 GPU 上分离开来。这使得每个阶段的特定需求可以进行单独优化,并确保更大程度地利用 GPU 资源。

在 GPU 数量相同的情况下,Dynamo 可将 NVIDIA Hopper 平台上运行 Llama 模型的 AI 工厂性能和收益翻倍。在由 GB200 NVL72 机架组成的大型集群上运行 DeepSeek-R1 模型时,NVIDIA Dynamo 的智能推理优化也可将每个 GPU 生成的 token 数量提高 30 倍以上。

为了提升这些推理性能,NVIDIA Dynamo 加入了一些功能,使其能够提高吞吐量的同时降低成本。它可以根据不断变化的请求数量和类型,动态添加、移除和重新分配 GPU,并精确定位大型集群中的特定 GPU,从而更大限度地减少响应计算和路由查询。此外,它还可以将推理数据卸载到成本更低的显存和存储设备上,并在需要时快速检索这些数据,最大程度地降低推理成本。

NVIDIA Dynamo 完全开源并支持 PyTorch、SGLang、NVIDIA TensorRT-LLM 和 vLLM,使企业、初创公司和研究人员能够开发和优化在分离推理时部署 AI 模型的方法。这将使用户加速采用 AI 推理,包括亚马逊云科技、Cohere、CoreWeave、戴尔科技、Fireworks、谷歌云、Lambda、Meta、微软 Azure、Nebius、NetApp、OCI、Perplexity、Together AI 和 VAST。

NVIDIA Dynamo 包含四项关键创新,可降低推理服务成本并改善用户体验:

• GPU 规划器 (GPU Planner):一种规划引擎,可动态地添加和移除 GPU,以适应不断变化的用户需求,从而避免 GPU 配置过度或不足。

• 智能路由器 (Smart Router):一个具备大语言模型 (LLM) 感知能力的路由器,它可以在大型 GPU 集群中引导请求的流向,从而最大程度减少因重复或重叠请求而导致的代价高昂的 GPU 重复计算,释放出 GPU 资源以响应新的请求。

• 低延迟通信库 (Low-Latency Communication Library):推理优化库,支持先进的 GPU 到 GPU 通信,并简化异构设备之间的复杂数据交换,从而加速数据传输。

• 显存管理器 (Memory Manager):一种可在不影响用户体验的情况下,以智能的方式在低成本显存和存储设备上卸载及重新加载推理数据的引擎。

NVIDIA Dynamo 将作为 NVIDIA NIM微服务推出,并在未来版本中由 NVIDIA AI Enterprise 软件平台提供支持,具有生产级的安全性、支持和稳定性。

NVIDIA基于Llama开发了全新Llama Nemotron推理模型系列,提供Nano、Super、Ultra版本。其中Super 49B版本在生成速度和AI智能体任务的准确性两个维度超过DeepSeek-R1,吞吐量达到Llama 3.3 70B、DeepSeek R1 Llama 70B的5倍。

NVIDIA正为全球企业提供构建AI智能体的核心模块,推动企业级AI技术的普及与创新。英伟达的Llama Nemotron可以在任何地方运行,包括DGX Spark、DGX Station以及OEM制造的服务器上,甚至可以将其集成到任何AI智能体框架中。

未来,NVIDIA不仅会雇佣ASIC设计师,还会与Cadence合作,引入数字ASIC设计师来优化芯片设计。Cadence正在构建他们的AI智能体框架,英伟达的模型、NIM和库已经深度集成到他们的技术中。Capital One、德勤、纳斯达克、SAP、ServiceNow、Accenture、Amdocs等企业也将英伟达技术深度融入AI框架中。

NVIDIA物理AI生态逐渐成型

在黄仁勋整个GTC的主题分享中,涉及到物理AI的时长虽然不多,但其在自动驾驶和机器人部分的野心却很大。NVIDIA想在数据、算法、算力上全面发力。在算力上,NVIDIA有之前发布的 Orin 和 Thor 芯片。在数据上,NVIDIA也是重要的贡献者。物理 AI 强调让 AI 能够理解物理世界,而世界在过去并没有像积累文字和视频数据一样,积累足够多的 3D 环境数据。要大量产生数据,还得看NVIDIA推动的仿真数据的进展。

在生产流程方面,NVIDIA也逐渐补全,现在已经有了Omniverse和Cosmso。其中,Omniverse 数字孪生环境,相当于一个超强的 3D 编辑器,能够生成逼真的场景和物品。开发者可以根据不同的领域、机器人类型和任务,整合真实世界的传感器数据或示范数据。

Cosmos 模型训练平台,相当于一个专门为汽车和机器人搭建的虚拟世界,利用 Omniverse 训练 Cosmos,能够让 Cosmos 生成无限多样的虚拟环境,创建既受控、又具备系统性无限扩展能力的数据。

两者结合,就能产出无限多各种各样环境、光线、布景的虚拟仿真数据。

自动驾驶方面,NVIDIA宣布与通用汽车(GM)合作,共同打造未来的自动驾驶车队。人形机器人方面,NVIDIA发布首个开源人形机器人功能模型GR00T N1;还与 DeepMind、Disney Research联合推出了针对机器人研发的新物理引擎 Newton。

在发布会结束阶段,Blue机器人登台亮相。机器人内置了两个NVIDIA芯片,训练则是完全是在NVIDIA的建设的训练体系和Newton引擎中,通过实时模拟完成的。

全部评论