随着NVIDIA A100/H100计算卡的热卖,对HBM(High Bandwidth Memory)的需求也空前高涨,动辄单卡几十GB,最近宣布的Grace Hopper超级芯片,双路系统就需要282GB HBM3E。

美光的HBM3E,又叫第二代HBM3,采用了1βnm工艺制造,单颗容量24GB,堆叠了八颗24Gb Die,数据率最高9.7GT/s,意味着峰值高达1.2TB/s,比市面最快方案高出44%。

同时,美光还在准备12颗堆叠,容量可达32GB,将在明年推出。

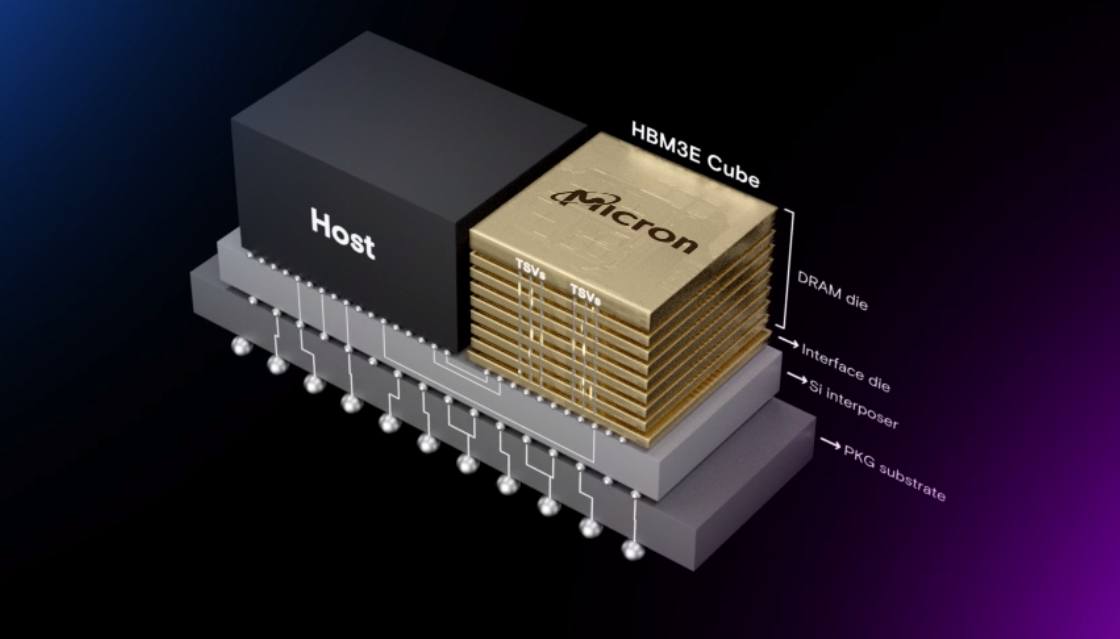

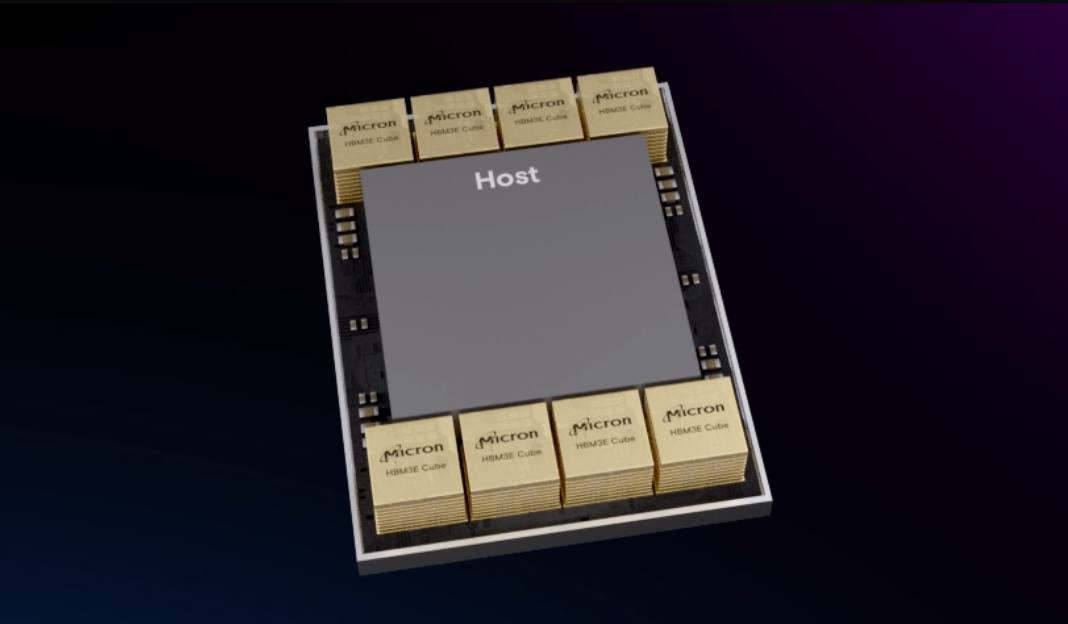

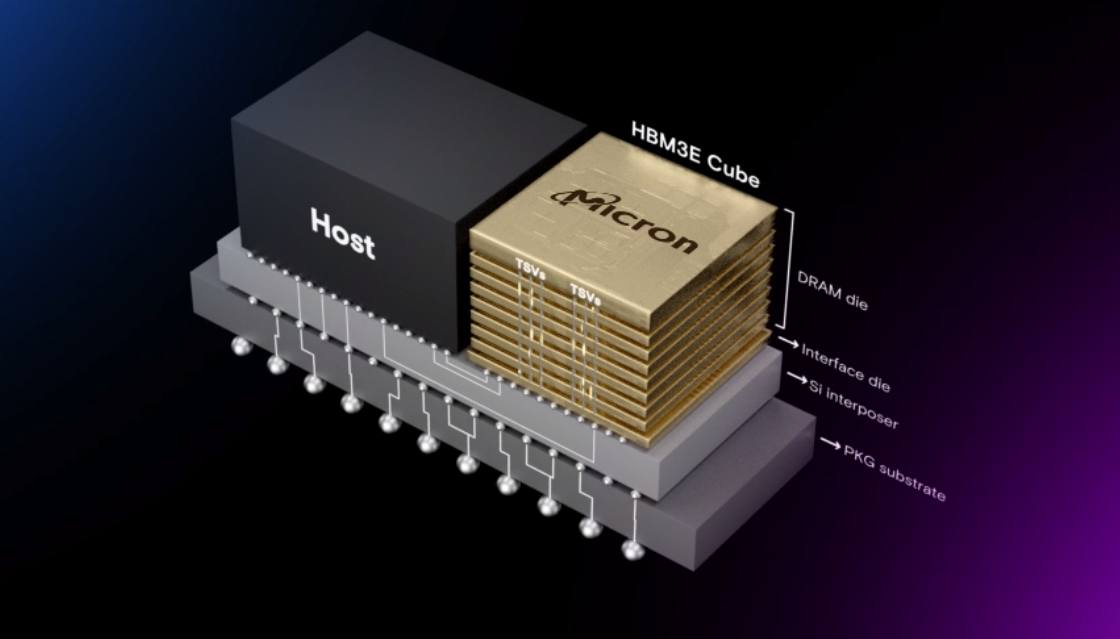

HBM是指垂直连接多个 DRAM,可显著提升数据处理速度,HBM DRAM 产品以 HBM(第一代)、HBM2(第二代)、HBM2E(第三代)、HBM3(第四代)、HBM3E(第五代)的顺序开发。HBM3E 是 HBM3 的扩展(Extended)版本。

最近,在23Q4的财报电话会议上,美光透露说,计划在2024年初开始大批量出货其 HBM3E 内存,同时还透露,目前已经在其新内存的主要客户之一的NVIDIA那边验证。同时,该公司强调其新产品受到了整个行业的极大关注,并暗示NVIDIA很可能不是唯一最终使用美光 HBM3E的客户。

美光科技总裁兼首席执行官 Sanjay Mehrotra 在公司财报电话会议上表示:"我们推出的 HBM3E 产品受到了客户的强烈关注和热捧。"

老实说,美光在HBM市场上处于劣势,仅占10%的市场份额,大幅落后于其竞争对手三星和SK Hynix。如今领先于竞争对手推出HBM3E(该公司也称之为 HBM3 Gen2)对美光来说是一件大事。这次,美光显然对其HBM3E寄予了厚望,因为这很可能使其领先于竞争对手(赢得市场份额)提供优质产品(提高收入和利润)。

通常情况下,内存制造商往往不会透露其客户的名称,但这次美光强调,其HBM3E 是客户路线图的一部分,并特别提到NVIDIA是其盟友。与此同时,NVIDIA 迄今公布的唯一支持 HBM3E 的产品是其 Grace Hopper GH200 计算平台,该平台采用了 H100 计算 GPU 和 Grace CPU。

Mehrotra说:"在整个开发过程中,我们一直与客户密切合作,并正在成为他们人工智能路线图中紧密结合的合作伙伴。美光HBM3E目前正处于英伟达计算产品的资格认证阶段,这将推动HBM3E驱动的人工智能解决方案的发展。"

全部评论